ทำไมบริษัทเทคโนโลยีถึงยังคงใช้จ่ายสูง?

ในช่วงที่ผ่านๆ มา เรามักจะได้ยินคำพูดอันหนึ่งที่พูดถึงการเติบโตของกลุ่มบริษัทเทคโนโลยี โดยเฉพาะกลุ่มที่เรียกๆ กันว่า Magnificent 7 หรือตัวอื่นๆ ที่กลับมาทำผลงานได้ดี โดยเฉพาะในเรื่องของผลตอบแทนหุ้น ที่ผู้รู้ทั้งหลายพยายามชี้ว่าการใช้จ่ายในเรื่องเทคโนโลยี โดยเฉพาะปัญญาประดิษฐ์ กำลังเป็นการใช้จ่ายที่สิ้นเปลืองและสภาวะปัจจุบันเข้าใกล้ความเป็นฟองสบู่ (bubble) เข้าไปทุกที บ้างก็ทำนายว่าฟองสบู่จะแตก บางคนไปไกลถึงกับว่านี่คือจุดจบของตลาดทุนที่จะมีสหรัฐอเมริกาเป็นผู้นำไปเลย

ข่าวที่เกี่ยวข้อง

อันที่จริงแล้วความกังวลเหล่านี้ก็ไม่ใช่ว่าจะไม่มีรากฐานเสียทีเดียวเนื่องจากปัจจุบันค่าอัตราส่วนราคาต่อกำไรต่อหุ้น (PER) ล่วงหน้า 12 เดือน (NTM: Next 12 Months) ของสหรัฐฯ ยืนอยู่ในระดับที่สูงมากในรอบหลายปี โดยดัชนี S&P 500 อยู่ที่ 22.6791 เท่า (29 กันยายน 2568)[1] เรียกว่ายืนสูงในระดับรอบหลายสิบปี และอยู่ไม่ไกลจากช่วงที่สูงสุดในวันที่ 12 เมษายน 2542 ที่ 25.5729 เท่า (Dot Com Bubble) ก่อนที่ฟองสบู่หุ้นสหรัฐฯ จะแตกและกลายเป็นความเจ็บปวดให้กับใครหลายๆ คน

เหตุผลหนึ่งที่ถูกหยิบยกขึ้นมาใช้ในการอธิบายความน่ากลัวนี้คือการที่บริษัทแต่ละแห่งใช้จ่ายกับเรื่องไอทีและเทคโนโลยีไปเยอะมาก โดยเฉพาะอย่างยิ่งสำหรับเรื่องปัญญาประดิษฐ์ (AI) ที่แต่ละบริษัทแข่งกันใช้จ่ายเงินเป็นว่าเล่น จนทำให้ผู้เชี่ยวชาญหลายฝ่ายออกมาระบุว่าเรากำลังใส่เงินจำนวนมากเข้าไปในสิ่งที่ประโยชน์จะเกิดขึ้นแบบใดยังไม่มีใครประเมินได้ และมันอาจทำให้ตลาดหุ้นรวมถึงเศรษฐกิจที่อยู่รอบๆ บริษัทเหล่านี้ พังลงได้ในวันที่ AI ถูกประเมินว่าไม่มีคุณค่าเพียงพอสำหรับตลาด เมื่อบริษัทเหล่านี้หยุดการใช้จ่ายลง

แม้เหตุผลเหล่านี้จะช่วยทำให้เราฉุกคิดขึ้นมาว่าอันที่จริงแล้วการใช้จ่ายในลักษณะนี้อาจกำลังส่งผลเสียในระยะยาวหรือไม่และเหตุผลนี้อาจทำให้เราคิดได้ว่าหุ้นสหรัฐอเมริกาตกอยู่ในความเสี่ยงจริงๆทว่าหากพิจารณากันตามจริงแล้ว จะพบว่าอันที่จริงการเติบโตทางเทคโนโลยีที่ต้องอาศัยพลังในการประมวลผลและจัดเก็บข้อมูลที่มากขึ้นเรื่อยๆ และเลี่ยงไม่ได้ที่เราจะต้องสร้างหรือลงทุนกับเทคโนโลยีเหล่านี้อยู่ตลอดเวลา

ตัวอย่างที่ใกล้ตัวที่สุดคือปริมาณข้อมูลบนมือถือเรา ย้อนกลับไปราว 10 ปีก่อนในสมัย iPhone 6s รุ่นเริ่มต้นมีพื้นที่เก็บข้อมูลที่ 16 GB ภาพตัดมายัง ณ ปัจจุบันที่ iPhone 17 ออกมา ปริมาณความจุของพื้นที่เก็บข้อมูลเริ่มต้นกลายเป็น 256 GB คิดเป็นอัตราเพิ่มถึง 1500% หรือ 16 เท่า เฉลี่ยออกมาแต่ละปีจะอยู่ที่ 31.95% แม้สิ่งนี้จะบ่งชี้เพียงพื้นฐานในวงแคบ แต่ก็แสดงให้เห็นว่ามนุษย์นั้นมีข้อมูลเยอะขึ้น และการเติบโตของพื้นที่หน่วยความจำเก็บข้อมูลบ่งชี้ถึงการเปลี่ยนแปลงดังกล่าวได้

การที่มนุษย์มีข้อมูลรอบตัวมากขึ้นแม้กิจกรรมเดิมจะไม่เปลี่ยนแปลง (เนื่องจากตัวตรวจจับข้อมูลของแต่ละคนเริ่มเยอะขึ้น หรือมนุษย์เริ่มใช้งานกิจกรรมต่างๆ บนโลกดิจิทัลมากขึ้น) ทำให้ข้อมูลนั้นมีจำนวนมาก ปริมาณการจัดเก็บก็เพิ่มเยอะขึ้นด้วย เราคงได้ยินคำว่า “Big Data” อยู่บ่อยครั้ง ซึ่งปรากฏการณ์นี้คือการที่มีข้อมูลมากมายมหาศาลในการทำงานและการใช้งาน และส่วนมากมักเป็นข้อมูลที่ไม่มีโครงสร้าง (unstructured data) ซึ่งตรงกันข้ามกับข้อมูลที่มีโครงสร้างและเป็นระบบ (structured data)

การเติบโตของข้อมูลเหล่านี้ ย่อมนำไปสู่สองทิศทางที่สำคัญ ประการแรกคือการจัดเก็บข้อมูลที่ต้องเติบโตตามขนาดของข้อมูลที่ตามไปด้วย สถิติจาก Domo บริษัทด้านข้อมูลระบุว่ามนุษย์สร้างข้อมูลกว่า 2.5 ล้านล้านล้านไบต์ภายใน 1 วัน[2] การเติบโตของข้อมูลมากมายขนาดนี้ทำให้โครงสร้างพื้นฐาน อย่างเช่น ระบบจัดเก็บข้อมูล และคลาวด์ต้องเติบโตไปพร้อมกันด้วย เพื่อที่จะรองรับข้อมูลที่มีจำนวนมหาศาลได้ ในเวลาเดียวกัน และอีกทิศทางหนึ่งคือการใช้ประโยชน์จากข้อมูลเหล่านั้น ซึ่งก็ต้องใช้ปัญญาประดิษฐ์ (AI) ในการใช้ประโยชน์จากข้อมูลเหล่านี้

ภาพที่ 1: พัฒนาการของเทคโนโลยีในยุคร่วมสมัย (ที่มา: XSpring Asset Management Investment Research & Strategy)

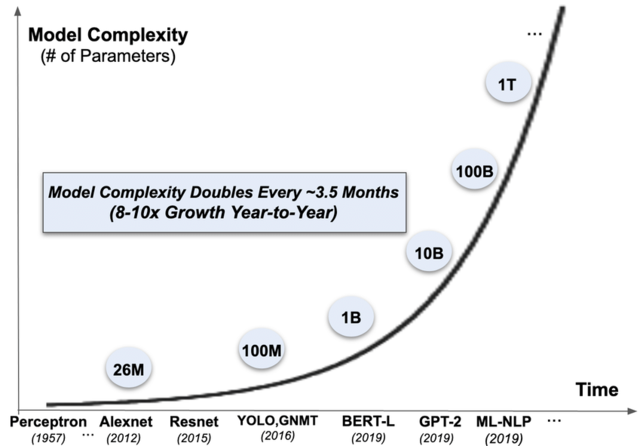

ปัญหาสำคัญของโมเดลในงานปัญญาประดิษฐ์ คือการเติบโตขึ้นของชุดคำสั่งทำงาน (parameters) ที่รองรับนั้นเพิ่มสูงขึ้นมาก จากงานวิจัยของ Eren Kurshan, Hongda Shen, and Jiahao Chen (2020)[3] ทำนายว่าความซับซ้อนของโมเดลเหล่านี้เพิ่มขึ้นสองเท่าตัวในทุกๆ 3.5 เดือน คิดเป็นอัตราการเติบโตที่ 8-10 เท่า ต่อปี ทำให้กำลังการประมวลผลที่ต้องใช้มากขึ้นไปเรื่อยๆ เมื่อต้องการกำลังการประมวลผลที่มากขึ้นไปเรื่อยๆ การประมวลผลหรือเทคโนโลยีดั้งเดิมก็ติดข้อจำกัด และต้องใช้พลังงานเป็นจำนวนมาก ดังนั้นจึงต้องลงทุนใหม่เพื่อให้ตอบสนองต่อความเปลี่ยนแปลงนี้ได้อย่างชัดเจน

ภาพที่ 2: ความซับซ้อนของโมเดลด้านปัญญาประดิษฐ์ (ที่มา: Kurshan, Eren & Shen, Hongda & Chen, Jiahao. (2020)

การลงทุนใหม่เพื่อรองรับทั้งปริมาณข้อมูลที่มากขึ้น และกำลังการประมวลที่มากขึ้นเหล่านี้ นำไปสู่การแตกออกเป็นสองสายของการพัฒนาที่สำคัญที่มีหัวใจอยู่ที่การเพิ่มประสิทธิภาพในการประมวลผลมากขึ้น

- สายหนึ่งคือการใช้ประโยชน์จากโครงสร้างของ Cloud Computing ที่มีศูนย์ข้อมูล (data center) เป็นศูนย์กลาง เนื่องจากหัวใจของ Cloud Computing คือความยืดหยุ่น (flexibility) ในการเพิ่มการใช้งานตามความต้องการ ซึ่งเกิดขึ้นครั้งแรกจากการนำเสนอบริการของ AWS (Amazon Web Services) เมื่อปี 2002[4] ซึ่งการสร้างศูนย์ข้อมูลนั้นมักกินเวลาราว 2.5-3.5 ปี รวมถึงขั้นตอนในการจัดหาพลังงานด้วย การใช้ประโยชน์จาก Cloud Computing จึงเป็นวิธีที่ง่ายที่สุด การที่ความต้องการใช้พลังงานประมวลผลที่มากขึ้นเรื่อยๆ ก็ทำให้ขนาดของศูนย์ข้อมูลต้องเติบโตไปด้วย และบางทีก็ไม่ทันต่อความต้องการ ทำให้บริษัทที่ให้บริการด้านคลาวด์รายใหญ่ (Hyperscaler เช่น Microsoft, Google, Oracle, Amazon) จำเป็นต้องเลือกทางเร็ว ด้วยการเช่าศูนย์ข้อมูลหรือพื้นที่ในการติดตั้งอุปกรณ์ของตนเอง ซึ่งกลุ่มเหล่านี้มักเป็น Carrier-Neutral Data Center หรือศูนย์ข้อมูลที่มีความเป็นกลางต่อผู้ให้บริการเครือข่าย ดังนั้นเราอาจเดินไปเจอเครื่องคอมพิวเตอร์ของบริษัทที่เป็นคู่แข่งกันภายในพื้นที่ของศูนย์ข้อมูลเดียวกันก็ได้ ตัวอย่างของผู้ให้บริการเหล่านี้คือ Equinix, NextDC, Applied Digital หรือ Keppel DC REIT เป็นต้น

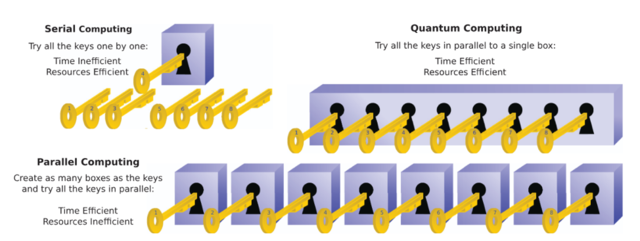

- ในขณะที่อีกสายหนึ่ง คือการพยายามพัฒนาเทคโนโลยีคอมพิวเตอร์สมัยใหม่ เพื่อให้มีความเร็วมากขึ้นในการประมวลผล หนึ่งในนั้นคือการพัฒนาสิ่งที่เรียกว่า ควอนตัมคอมพิวเตอร์ ที่นำเอากลไกทางควอนตัมฟิสิกส์ ที่ทำงานได้รวดเร็วมากขึ้นกว่าเดิม เนื่องจากคอมพิวเตอร์ในปัจจุบันที่ใช้ทรานซิสเตอร์ที่เป็นสารกึ่งตัวนำ (semiconductor) รองรับ 1 หน่วยข้อมูลในรูปแบบ 0 (ปิด) และ 1 (เปิด) เหมือนสวิตช์ไฟฟ้าที่ใช้ตามบ้าน แต่ 1 หน่วยข้อมูลของโลก Quantum สามารถเป็นได้ทั้ง 0 และ 1 ไปพร้อมๆ กัน ขึ้นอยู่กับสถานะของอิเล็กตรอนใน Qubit ที่เปลี่ยนแปลงไปตามพลังงานที่เปลี่ยนไปด้วย ทำให้การประมวลต่างๆ นั้นเร็วขึ้นกว่าเดิม เปรียบเทียบอีกมุมหนึ่ง คอมพิวเตอร์แบบเดิมประมวลผลเหมือนมีกุญแจแปดดอก แต่ต้องทดลองไขแม่กุญแจอันเดียว ซึ่งสามารถแก้ได้ด้วยการมีแม่กุญแจหลายๆ อันแต่ช่องเสียบกุญแจมีช่องเดียว ทำให้ต้องทำซ้ำแม่กุญแจใหม่สำหรับกุญแจแต่ละอัน ซึ่งต้องใช้เวลานาน คอมพิวเตอร์ควอนตัมเหมือนแม่กุญแจที่มีเพียงอันเดียว แต่มีช่องให้เสียบลูกกุญแจได้หลายช่อง และไขพร้อมกันได้ ทำให้ประหยัดเวลาและทรัพยากรที่ต้องใช้[5]

ภาพที่ 3: เปรียบเทียบการทำงานของ Quantum Computer (ที่มา P. Botsinis, S. X. Ng and L. Hanzo, 2013)

และนี่คือเหตุผลว่าการพัฒนาของสิ่งเหล่านี้ทำให้บริษัทด้านเทคโนโลยีหลายแห่งยังคงต้องมีค่าใช้จ่ายด้านการลงทุน (CAPEX: Capital Expenditure) อย่างต่อเนื่อง และทำให้เกิดความต้องการอย่างต่อเนื่อง บริษัทที่เกี่ยวข้องในสายห่วงโซ่อุปทาน (supply chain) เหล่านี้ก็ยังคงจะต้องลงทุนอย่างต่อเนื่องไป จนกว่าเทคโนโลยีเหล่านี้จะถึงทางตัน ซึ่งก็คงจะอีกนานกว่าที่จะถึงจุดนั้นครับ และสมมติว่าถึงจุดนั้นแล้ว โครงสร้างพื้นฐานเหล่านี้ที่ได้มาจะเป็นการต่อยอดให้กับเทคโนโลยีอื่นๆ แบบเดียวกับที่ Cloud Computing เป็นฐานให้กับ Internet of Things ที่นำไปสู่ Big Data และ Machine Learning ก่อนจะมาเป็น Artificial Intelligence (AI) แบบที่เห็นอยู่ในปัจจุบันนั่นเองครับ

ที่มาข้อมูล:

[1] Source: Bloomberg

[2]https://web-assets.domo.com/blog/wp-content/uploads/2017/07/17_domo_data-never-sleeps-5-01.png

[3] Kurshan, Eren & Shen, Hongda & Chen, Jiahao. (2020). Towards Self-Regulating AI: Challenges and Opportunities of AI Model Governance in Financial Services. 10.48550/arXiv.2010.04827.

[4] Qian, Ling & Luo, Zhiguo & Du, Yujian & Guo, Leitao. (2009). Cloud Computing: An Overview. 5931. 626-631. 10.1007/978-3-642-10665-1_63.

[5] P. Botsinis, S. X. Ng and L. Hanzo, "Quantum Search Algorithms, Quantum Wireless, and a Low-Complexity Maximum Likelihood Iterative Quantum Multi-User Detector Design," in IEEE Access, vol. 1, pp. 94-122, 2013, doi: 10.1109/ACCESS.2013.2259536.

วิศรุต กิตติอาภรณ์พล

นักวิเคราห์ะกลยุทธ์การลงทุน บริษัทหลักทรัพย์จัดการกองทุนรวม เอ็กซ์สปริง จำกัด